网络爬虫,也称为蜘蛛、机器人或简单的爬虫,是一种程序或脚本,用于浏览万维网以获取页面内容。它的主要目的是系统地浏览和索引网页内容,以便搜索引擎能够提供更快、更准确的搜索结果。网络爬虫广泛应用于各种场合,包括搜索引擎使用爬虫收集网页信息并构建庞大的索引数据库。它们还用于从网站中抓取数据,以进行市场分析、竞争对手分析以及监控网页内容变化(如价格波动、新闻更新等)。此外,爬虫还会在特定领域收集信息,用于学术研究等更多用途。

网络爬虫是如何工作的?

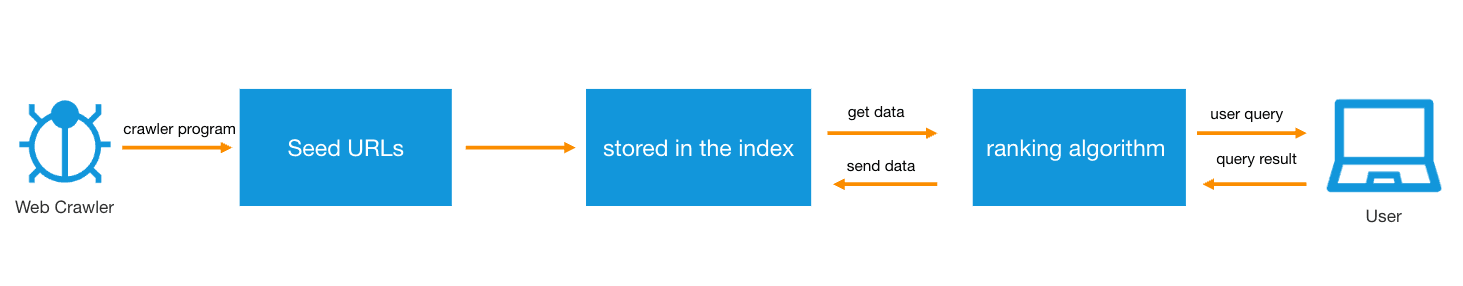

网络爬虫通常从一组已知的 URL 开始,这些 URL 被称为种子 URL。爬虫首先访问这些 URL 的网页。在访问过程中,爬虫下载页面内容并解析 HTML 代码,以提取有用的信息,如文本、图像和视频。

与此同时,爬虫识别并提取页面上的所有超链接。提取的链接将被添加到爬虫待爬列表中。这个过程使得爬虫可以从最初的种子 URL 扩展到更多网页。爬虫需要搜索数十亿个网页。为了实现这一目标,它们主要通过内部链接确定路径。如果页面 A 在其内容中链接到页面 B,爬虫就可以根据该链接从页面 A 移动到页面 B,然后处理页面 B。这就是为什么内部链接对 SEO 如此重要。它帮助搜索引擎爬虫找到并索引您网站上的所有页面。

在爬取任何网页之前,爬虫会检查网站的 robots.txt 文件,以了解网站管理员设置的关于哪些页面可以被爬取、哪些不可以被爬取的规则。爬虫不会盲目地爬取所有页面,而是基于一系列指标决定页面的爬取优先级,例如其他网页链接该页面的次数、流量以及页面内容的重要性潜力。这有助于优化资源利用,优先爬取最有价值的数据。

由于互联网内容不断更新和变化,爬虫需要定期重新访问已爬取的页面,以确保索引中的信息是最新的。爬虫存储获取的数据,并进行处理和索引,以便搜索引擎能够快速检索。

不同的搜索引擎可能会根据其需求和目标自定义爬虫的行为。例如,一些搜索引擎可能会优先爬取用户流量高或品牌影响力强的网站。

爬取与抓取的区别

网络抓取(也称为数据抓取或内容抓取)通常指的是在未获得网站许可的情况下下载网站内容。这种行为可能出于恶意目的,例如将抓取的内容用于非法复制或发布。相比之下,网络抓取往往更具针对性,可能仅限于特定页面或特定网站。

网络爬取涉及通过跟随链接系统地访问网页,从而持续爬取页面。网络爬虫,尤其是那些由搜索引擎使用的合法爬虫,在执行过程中可能会考虑对网络服务器造成的压力,遵守 robots.txt 文件的规定,并适当限制请求频率,以减少服务器负载。

抓取工具用于从网页或整个网站中提取数据。虽然这些工具可用于数据分析和市场研究等合法目的,但恶意行为者也使用这些工具来盗取和重新发布网站内容,可能侵犯版权并窃取原始网站的 SEO 成果。

网络爬虫主要有四种基本类型:

- 聚焦爬虫搜索和下载与特定主题相关的网络内容并对其进行索引。这些爬虫只关注它们认为相关的链接,而不是像标准网络爬虫那样浏览网页上的每个超链接。

- 增量爬虫重新访问网站以刷新索引和更新 URL。

- 并行爬虫同时运行多个爬取进程,以最大化下载速率。

- 分布式爬虫同时使用多个爬虫来索引不同的网站。

常见的网络爬虫包括:

- 谷歌,Googlebot(实际上是两个爬虫工具,Googlebot Desktop 和 Googlebot Mobile,分别用于桌面和移动设备搜索)

- Bingbot,微软搜索引擎的爬虫

- Amazonbot,亚马逊的网络爬虫

- DuckDuckBot,DuckDuckGo 搜索引擎的爬虫

- YandexBot,Yandex 搜索引擎的爬虫

- Baiduspider,中国搜索引擎百度的网络爬虫

- Slurp,雅虎的网络爬虫

- 优惠券应用程序,如 Honey

网络爬虫工具种类繁多,每种工具都有其独特的功能,适合不同的需求和技术水平。以下是一些常见的网络爬虫工具:

- Scrapy:一个非常强大的开源网络爬虫框架,使用 Python 开发。Scrapy 适用于复杂的网络爬取任务,支持异步请求处理,能够快速获取大量数据。

- Beautiful Soup:一个用于解析 HTML 和 XML 文档的 Python 库。它可以与 Python 的 Requests 库轻松结合使用,从网页中提取数据。

- Selenium:虽然主要用于自动化网页应用程序,但 Selenium 也可以作为网络爬虫使用,特别适用于交互式抓取任务,例如模拟点击和表单提交。

- Puppeteer:一个 Node.js 库,可以控制无头版本的 Chrome 或 Chromium 浏览器,适合抓取重 JavaScript 的应用程序。

- Curl:一个可以在命令行或脚本中使用 URL 语法的工具,可用于获取网页内容和文件。

- Wget:一个用于自动下载文件的命令行工具

- Apache Nutch:这是一个高度可扩展的开源网络爬虫软件项目。Nutch 可以在 Apache Hadoop 集群上运行,适合大规模数据抓取。

- Octoparse:这是一个用户友好的无代码网页抓取工具,允许用户通过可视化界面快速设置抓取任务。

- ParseHub:这是一个现代的视觉数据抓取工具,支持复杂的数据抓取需求,例如处理 AJAX 和 JavaScript。ParseHub 提供了一个干净的图形界面,使非技术用户能够轻松抓取数据。

- Common Crawl:这不是一个工具,而是一个开源项目,提供大规模的网页数据集。它为研究人员和公司提供访问预抓取网页数据的机会,可以直接使用,无需自己爬取。

这些工具各具特色,用户可以根据自身需求和技术能力选择适合的网络抓取工具。对于编程技能较强的用户,Scrapy 和 Beautiful Soup 提供了极大的灵活性和控制;而对于寻求简单易用解决方案的用户,Octoparse 和 ParseHub 等工具则提供用户友好的界面和快速的数据抓取能力。

网络爬虫对SEO的影响

搜索引擎优化(SEO)是指使用户更容易搜索网站上特定类型的内容、产品或服务的实践。不易被爬取的网站在搜索引擎结果页面(SERPs)上的排名较低。完全无法被爬取的网站将不会出现在结果页面上。为了提高搜索引擎排名,SEO 团队需要消除错误,例如缺失页面标题、重复内容和损坏链接,因为这些都会增加爬取和索引网站的难度。

机器人管理与爬虫之间的关系

恶意机器人访问您的网站可能造成重大损害,从糟糕的用户体验和服务器崩溃到数据盗窃,随着时间推移而加剧。然而,在阻止恶意机器人时,仍然重要的是要允许善意机器人的访问能力,例如网络爬虫。Tencent EdgeOne 机器人管理 允许善意的爬虫继续访问网站,同时减少恶意机器人流量。该产品自动更新善意爬虫的白名单,确保其顺利运行,并在相似水平上提供对其机器人流量的可见性和控制。

如果您希望保护您的网站免受恶意攻击,同时允许合理的爬虫访问以增强您的 SEO 能力,请随时尝试 Tencent EdgeOne 以获得保护和加速。