ウェブクローラー、一般的にはスパイダー、ボット、単にクローラーとも呼ばれるものは、ページコンテンツを取得するためにワールドワイドウェブをナビゲートするプログラムまたはスクリプトです。その主な目的は、ウェブページのコンテンツを体系的にブラウズしインデックス化することで、検索エンジンがより迅速かつ正確な検索結果を提供できるようにすることです。ウェブクローラーは、検索エンジンがウェブページ情報を収集し、大規模なインデックスデータベースを構築するために広く使用されています。また、マーケット分析や競合分析、価格変動やニュース更新などのウェブコンテンツの変更を監視するために、特定のデータをウェブサイトからスクレイピングする目的でも使われます。さらに、学術研究などの特定分野の情報を収集するためにも利用されます。

ウェブクローラーはどのように機能するのか?

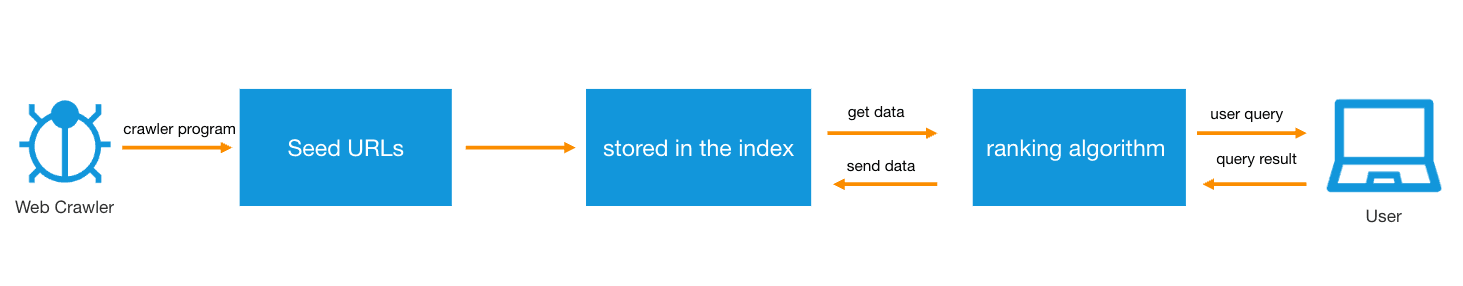

ウェブクローラーは通常、シードURLと呼ばれる既知のURLのセットから始まります。クローラーは最初にこれらのURLのウェブページを訪れます。訪問中、クローラーはページコンテンツをダウンロードし、HTMLコードを解析してテキスト、画像、動画などの有用な情報を抽出します。

同時に、クローラーはページ上のすべてのハイパーリンクを特定し、抽出します。抽出されたリンクは、クローラーのクロールするページのキューに追加されます。このプロセスにより、クローラーは初期のシードURLからさらに多くのウェブページに拡張できます。クローラーは数十億のウェブページを検索する必要があります。これを実現するために、彼らは主に内部リンクによって決定されたパスに従います。ページAがその内容でページBにリンクしている場合、ボットはそのリンクに基づいてページAからページBに移動し、その後ページBを処理できます。これがSEOにおいて内部リンクが非常に重要である理由です。それは、検索エンジンクローラーがあなたのウェブサイト上のすべてのページを見つけてインデックス化するのを助けます。

クローラーは、ウェブページをクロールする前に、サイトのrobots.txtファイルをチェックして、ウェブサイト管理者が設定したどのページがクロール可能であり、どのページがクロール不可能かを理解します。クローラーはすべてのページを盲目的にクロールするわけではなく、他のウェブページによってリンクされている回数、トラフィック量、ページコンテンツの潜在的重要性など、一連の指標に基づいてページのクロール優先度を決定します。これにより、リソースの使用を最適化し、最も価値のあるデータのクロールを優先します。

インターネット上のコンテンツは常に更新され変化しているため、クローラーはクロールしたページを定期的に再訪して、インデックス内の情報が最新であることを確認する必要があります。クローラーは取得したデータを保存し、それを処理してインデックス化し、検索エンジンが迅速に取得できるようにします。

異なる検索エンジンは、そのニーズや目的に基づいてクローラーの挙動をカスタマイズする場合があります。たとえば、いくつかの検索エンジンは、高いユーザートラフィックや強力なブランド影響力を持つサイトのクロールを優先することがあります。

クロールとスクレイピングの違い

ウェブスクレイピング(データスクレイピングまたはコンテンツスクレイピングとも呼ばれる)は、一般的にウェブサイトのコンテンツをウェブサイトの許可なしにダウンロードする行為を指します。この行為は、違法コピーや公開のためにスクレイピングされたコンテンツを使用するなどの悪意のある目的のために行われることがあります。それに対して、ウェブスクレイピングは通常、特定のページや特定のサイトに限定される可能性がある、よりターゲットを絞った行為です。

ウェブクロールは、リンクを辿ってウェブページに体系的にアクセスすることを含みます。特に検索エンジンが使用するような正当なクローラーは、実行中にネットワークサーバーへの負荷を考慮し、robots.txtファイルの規定に従い、サーバー負荷を軽減するために要求頻度を適切に制限します。

スクレイピングツールは、ウェブページやウェブサイト全体からデータを抽出するために使用されます。これらのツールは、データ分析や市場調査などの正当な目的にも使用できますが、悪意のある行為者もこれらのツールを使用してウェブサイトのコンテンツを盗み、不正に再公開し、著作権を侵害し、元のサイトのSEO結果を盗むことがあります。

ウェブクローラーには4つの基本的なタイプがあります:

- フォーカスクローラーは、特定のトピックに関連するウェブコンテンツを検索してダウンロードし、インデックス化します。これらのクローラーは、標準のウェブクローラーのようにウェブページ上のすべてのハイパーリンクをブラウズするのではなく、関連性があると考えるリンクのみに焦点を合わせます。

- インクリメンタルクローラーは、サイトを再訪してインデックスを更新し、URLを更新します。

- パラレルクローラーは、複数のクロールプロセスを同時に実行してダウンロード速度を最大化します。

- 分散クローラーは、同時に複数のクローラーを使用して異なるウェブサイトをインデックス化します。

一般的なウェブクローラーには以下のものがあります:

- Google、Googlebot(実際にはデスクトップとモバイルデバイスの検索に使用される二つのクロールツール、Googlebot DesktopとGooglebot Mobile)

- Bingbot、マイクロソフトの検索エンジンのクローラー

- Amazonbot、Amazonのウェブクローラー

- DuckDuckBot、検索エンジンDuckDuckGoのクローラー

- YandexBot、Yandex検索エンジンのクローラー

- Baiduspider、中国の検索エンジンBaiduのウェブクローラー

- Slurp、Yahooのウェブクローラー

- クーポンアプリケーション、例えばHoney

ウェブクローラーツールは数多くあり、それぞれに独自の機能があり、さまざまなニーズや技術レベルに適しています。以下は一般的なウェブクローラーツールです:

- Scrapy: Pythonで開発された非常に強力なオープンソースのウェブクローラーフレームワークです。Scrapyは、複雑なウェブクロールタスクに適しており、非同期リクエスト処理をサポートし、大量のデータを迅速に取得できます。

- Beautiful Soup: HTMLおよびXMLドキュメントを解析するためのPythonライブラリです。PythonのRequestsライブラリと簡単に組み合わせて、ウェブページからデータを抽出できます。

- Selenium: 主にウェブページアプリケーションを自動化するために使用されますが、インタラクティブなスクレイピングタスク、たとえばクリックやフォーム送信をシミュレーションするためにウェブクローラーとしても使用できます。

- Puppeteer: ヘッドレス版のChromeまたはChromiumブラウザを制御するNode.jsライブラリで、JavaScriptが重いアプリケーションのスクレイピングに適しています。

- Curl: コマンドラインやスクリプトでURL構文を使用して動作するツールで、ウェブページのコンテンツやファイルを取得するために使用できます。

- Wget: 自動的にファイルをダウンロードするためのコマンドラインツール

- Apache Nutch: これは非常にスケーラブルなオープンソースのウェブクローラーソフトウェアプロジェクトです。NutchはApache Hadoopクラスター上で実行でき、大規模なデータスクレイピングに適しています。

- Octoparse: ユーザーフレンドリーでノーコードのウェブスクレイピングツールで、視覚的なインターフェースを介して迅速にスクレイピングタスクを設定できます。

- ParseHub: AJAXやJavaScriptの処理など、複雑なデータスクレイピングニーズをサポートする現代的なビジュアルデータスクレイピングツールです。ParseHubは、非技術ユーザーが簡単にデータをスクレイピングできるクリーンなグラフィカルインターフェースを提供します。

- Common Crawl: これはツールではなく、ウェブページの大規模なデータセットを提供するオープンソースプロジェクトです。研究者や企業が事前にスクレイピングされたウェブデータにアクセスできるようにし、自分たちでクロールする必要なしに直接使用できます。

これらのツールはそれぞれ独自の機能を持ち、ユーザーは自分のニーズや技術能力に基づいてウェブスクレイピングに適したツールを選択できます。プログラミングスキルが高いユーザーには、ScrapyやBeautiful Soupが柔軟性と制御を提供します。一方、簡単で使いやすいソリューションを求めるユーザーには、OctoparseやParseHubのようなツールがユーザーフレンドリーなインターフェースと迅速なデータスクレイピング能力を提供します。

ウェブクローラーのSEOへの影響

検索エンジン最適化(SEO)とは、特定の種類のコンテンツ、製品、サービスをウェブサイト上で検索しやすくするための実践を指します。クローリングが容易でないウェブサイトは、検索エンジン結果ページ(SERP)で低いランクになります。全くクロールできないウェブサイトは、結果ページに表示されません。検索エンジンランキングを改善するために、SEOチームは、ページタイトルの欠落、重複コンテンツ、壊れたリンクなど、ウェブサイト上のエラーを排除する必要があります。これらはクロールやインデックス化の難易度を高める可能性があります。

ボット管理とクローラーの関係

悪意のあるボットがあなたのサイトにアクセスすると、ユーザー体験の低下やサーバーのクラッシュ、データの盗難など、時間が経つにつれて重大な損害を引き起こす可能性があります。しかし、悪意のあるボットをブロックする一方で、ウェブクローラーのような善意のボットのアクセスを許可することも重要です。Tencent EdgeOne Bot managementは、悪意のあるボットトラフィックを減少させながら、善意のボットがウェブサイトにアクセスし続けられるようにします。この製品は、ウェブクローラーのような善意のボットのホワイトリストを自動的に更新し、スムーズな運用を保証し、ボットトラフィックに対する可視性と制御を提供します。

悪意のある攻撃からウェブサイトを保護しつつ、SEO機能を向上させるための合理的なクローラーアクセスを許可したい場合は、ぜひ Tencent EdgeOne を試して、保護と加速を実感してください。