Open Edge on EdgeOneの紹介: Open Edgeサーバーレス開発プラットフォームとAIゲートウェイ機能に関する包括的ガイド

Open Edgeとは何ですか?

より多くの開発者が参加し、協力し、エッジアプリケーションを改善することを促進するために、Tencent EdgeOneは、開発者向けのオープン技術共創プラットフォーム「Open Edge」を作成しました。私たちは、世界中でエッジノードの機能をさらに開放し、次世代のサーバーレスアプリケーションを共に探求し構築できるようにします。また、さまざまなアプリケーション選択肢を提供し、開発者が新しい世代のエッジサーバーレスアプリケーションを共同で探求し構築することを支援・促進する即時利用可能な体験も提供します。

Open Edgeアーキテクチャの概要

Open Edgeアーキテクチャは、エッジコンピューティングアプリケーションに取り組む開発者にシームレスな体験を提供するように設計されています。これは、サーバーレスアプリケーションレイヤー、エッジコンポーネントレイヤー、およびコンピューティングレイヤーの3つの主要な層で構成されています。それぞれの層は、エッジアプリケーションの効率的な実装と運用を確保する上で重要な役割を果たします。

1. サーバーレスアプリケーションレイヤー

軽量アプリケーションに焦点を当てたサーバーレスアプリケーションレイヤーは、メンテナンスフリーで即時利用可能な体験を開発者に提供します。現在、AIゲートウェイアプリケーションを無料で提供しており、開発者が大規模言語モデル(LLM)へのアクセスを管理し制御するのを助けます。ポスタージェネレーション、リアルタイムトランスコーディング、テキストから画像への変換などの追加アプリケーションも開発中で、近日中に利用可能となる予定です。

2. エッジコンポーネントレイヤー

エッジコンポーネントレイヤーは、エッジアプリケーションの実装に不可欠なコアコンポーネントで構成されています。これらのコンポーネントには、エッジファンクション、エッジキャッシュ、エッジKV、エッジCOS、およびエッジAIが含まれています。これらのビルディングブロックにより、開発者はネットワークのエッジでデータを効率的に処理・管理できる堅牢で高性能なアプリケーションを作成できます。

3. エッジコンピューティングレイヤー

エッジコンピューティングレイヤーは、エッジアプリケーションの実装に必要なコンピューティングパワーを提供します。これには、CPUやGPUなどの異種リソースが含まれており、アプリケーションがリアルタイムでデータを効率的に処理・分析できることを保証します。この層は、IoT、AI、リアルタイム分析などの多くのユースケースにおいて、エッジアプリケーションが低遅延で高性能な結果を提供できるようにする上で重要な役割を果たします。

Open Edgeの能力とは?

Open Edgeの主な利点は以下の通りです:

- サーバーレスアーキテクチャ:サーバーレスアーキテクチャを活用することで、リソースの利用効率が向上し、運用の複雑さが軽減されます。

- 無料サービス:基本的な無料アプリケーションサービスを提供し、開発者の初期コストを削減します。

- 即時利用可能な体験:ユーザーは複雑な設定なしですぐにサービスを利用開始できます。

- 共創プラットフォーム:開発者が参加し、協力し、アプリケーションを共に改善することを促進します。

- 多様なアプリケーション:さまざまなニーズに応える多様なアプリケーション選択肢を提供します。

Open Edgeに参加することで、以下の利点を享受できます:

- 無料でアクティブ化できます。

- AIゲートウェイは現在、開発者が無料トライアルを申請できる状態です。これにより、大規模言語モデル(LLM)へのアクセスを管理・制御でき、Open AI、Minimax、Moonshot AI、Gemini AI、Tencent Hunyuan、Baidu Qianfan、Alibaba Tongyi Qianwen、ByteDance DouBaoなどの主要なモデルサービスプロバイダーをサポートします。

Open Edgeに参加し、技術を使って世界を変えることを期待しています!

AIゲートウェイとは何ですか?

1. 機能概要

Tencent EdgeOne AIゲートウェイは、大規模言語モデル(LLM)サービスプロバイダーへのアクセスに対するセキュリティ、可視性、およびリクエスト動作制御管理を提供します。現在、AIゲートウェイは開発者が無料トライアルを申請できる状態です。

AIゲートウェイは、キャッシュ構成機能をサポートしており、開発中の機能には、レート制限、リクエストの再試行、LLMモデルのフォールバック、および仮想キーが含まれています。これらの機能の組み合わせにより、LLMサービスプロバイダーへのアクセスのセキュリティと安定性を効果的に確保し、アクセスコストを削減します。

注意:これは現在ベータ版であり、本番環境での使用は推奨しません。ビジネスリスクを慎重に考慮した上で、本番ビジネスでの使用を希望される場合はご注意ください。

2. 適用シナリオ

- 企業オフィス:従業員とLLMサービスプロバイダーの間にAIゲートウェイを設置し、従業員によるLLMサービスプロバイダーへの安全なアクセスとコスト管理を制御するのに適しています。

- 個人開発:AIGCの個人開発者が、消費者ユーザーとLLMサービスプロバイダーの間にAIゲートウェイを設置し、消費者ユーザーのリクエスト動作を制御するのに適しています。

3. 機能の利点

- コスト削減:キャッシュ技術を利用することで、繰り返しのプロンプトリクエストにはキャッシュから直接応答が提供され、再度LLMサービスプロバイダーを呼び出す必要がなくなります。これにより、不必要な重複コストを回避し、運用費用を大幅に削減できます。

- 柔軟な構成:リクエストの再試行、レート制限、LLMモデルのフォールバックなどの機能は、さまざまな例外や複雑なシナリオに対応するために構成でき、サービスの可用性を確保します。

- データ監視:データダッシュボードを通じて、AIゲートウェイリクエストに関する詳細な統計情報を取得できます。このデータは、トラフィックパターンの洞察を得て、ビジネスプロセスを最適化し、より正確なビジネス判断を行うのに役立ちます。

- 高いセキュリティ:仮想キー技術は、追加のセキュリティ層を提供します。このメカニズムにより、LLMサービスプロバイダーのアクセスキーが漏洩せず、データセキュリティとビジネスプライバシーが保護されます。

注意:上記のすべての機能が現在利用可能なわけではありません。特定の機能に特に興味がある場合は、製品チームにフィードバックを提供してください。

4. LLMサービスプロバイダー

Open AI、Minimax、Moonshot AI、Gemini AIなどの主要モデルサービスプロバイダーのサポートが既に利用可能で、さらに多くのプロバイダーが開発中です。

操作ガイド

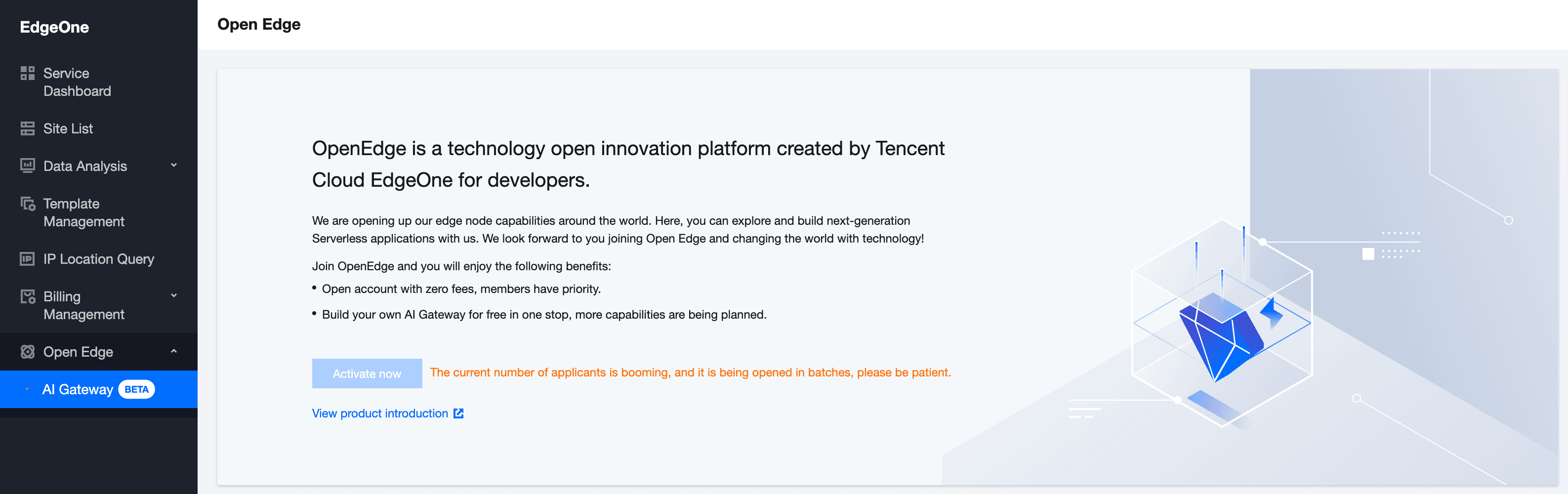

1. Open Edgeを有効化する

Open Edgeにアクセスするには、Tencent EdgeOne Consoleに移動し、左側のサイドバーでOpen Edgeをクリックします。以前にアクセスを申請していない場合は、「今すぐ有効化」をクリックして使用権限を要求する必要があります。

注意:現在、限られたユーザーテストをバッチで実施しているため、今回の申請が承認されなかった場合は、辛抱強くさらなる更新をお待ちください。ご理解いただきありがとうございます。

2. AIゲートウェイを作成する

有効化に成功した後、AIゲートウェイリストページに移動し、「作成」をクリックします。ポップアップの指示に従って、名前と説明を入力します。

- 名前:必須項目で、作成後は変更できず、数字、大文字、小文字、ハイフン、アンダースコアのみを含むことができ、重複名は許可されません。

- 説明:任意項目で、最大長は60文字です。

3. AIゲートウェイを構成する

AIゲートウェイを正常に作成した後、AIゲートウェイリストページに移動し、「詳細」または特定のAIゲートウェイインスタンスIDをクリックしてゲートウェイの詳細ページに入ります。現在、キャッシュ構成がサポートされています。

- 有効化/無効化:スイッチをオンにしてキャッシュを有効にすると、同じプロンプトリクエストに対してゲートウェイがキャッシュから直接応答し、LLMサービスプロバイダーへのリクエストを行わなくなります。スイッチをオフにするとキャッシュが無効になり、各リクエストはLLMサービスプロバイダーによって処理されます。

- キャッシュ期間の設定:サポートされるキャッシュ期間には、2分、5分、1時間、1日、1週間、1ヶ月があります。設定された期間が経過すると、キャッシュは自動的にクリアされます。

4. APIエンドポイント

AIゲートウェイバックエンドの対応エンドポイントは、大規模言語モデル(LLM)サービスプロバイダーです。現在、Open AI、Minimax、Moonshot AI、Gemini AIなどの主要モデルサービスプロバイダーがサポートされています。

例を参照し、Bearのxxxxxxxxxxxxxxxxxxxxxxxxをサービスプロバイダーのアクセスキー(例えばOpen AIのエンドポイント)に置き換えることができます。

ケースデモンストレーション

AIゲートウェイを介してOpen AIにアクセスする

操作シナリオ:AIゲートウェイでキャッシュを無効にし、AIゲートウェイを介してOpen AIにアクセスします。

AIゲートウェイでキャッシュを有効にし、再度アクセスします。

レスポンスヘッダーOE-Cache-StatusがHITを返す場合、キャッシュがヒットしたことを示します。

他のLLMサービスプロバイダーにAIゲートウェイを介してアクセスするには、上記の手順に従ってください。

FAQ

1. AIゲートウェイは無料ですか?

はい、AIゲートウェイは現在、開発者が無料トライアルを申請できる状態です。

2. AIゲートウェイは何ができますか?

AIゲートウェイは、大規模言語モデル(LLM)へのアクセスの管理と制御を可能にし、現在OpenAI、Minimax、Moonshot AI、Gemini AIなどの主要モデルサービスプロバイダーをサポートしています。

3. AIゲートウェイはもっと多くのLLMサービスプロバイダーをサポートできますか?

現在のLLMサービスプロバイダーが要件を満たさない場合は、ぜひお問い合わせください評価を依頼してください。